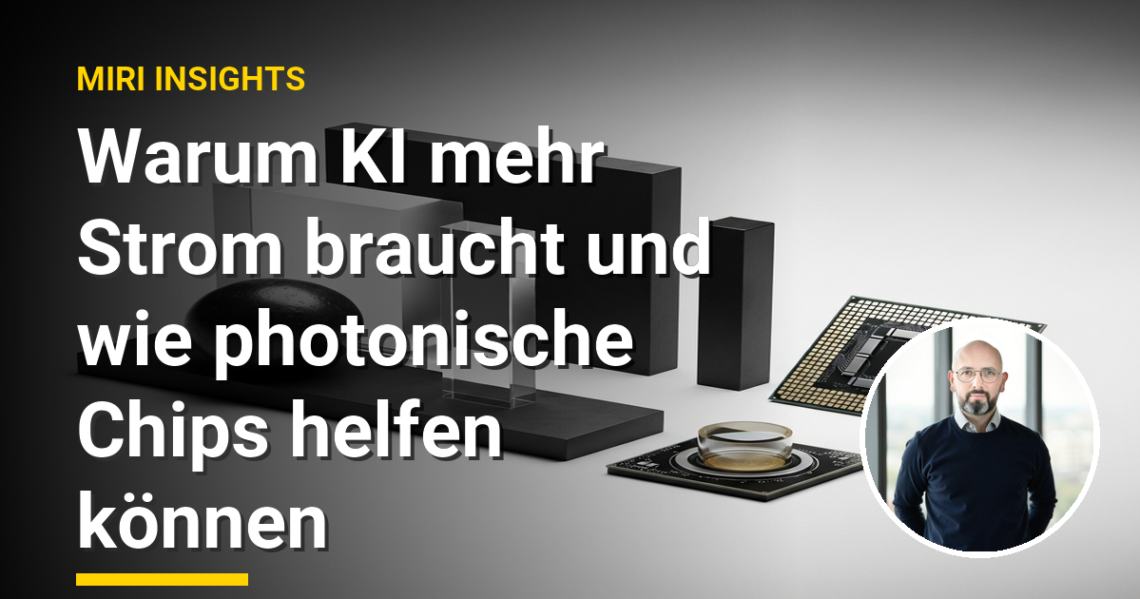

Warum KI mehr Strom braucht und wie photonische Chips helfen können

Stell dir vor, dein Computer würde das Licht anlassen, um dir Vorschläge zu machen. Genau das passiert, wenn KI-Modelle Rechenzentren auf Trab halten – mit einer Energiebilanz, die sich gewaschen hat.

Wo liegt das Problem?

Die Entwicklung moderner KI-Modelle frisst Unmengen an Energie. Beispielsweise benötigt ChatGPT täglich bis zu 0,6 Gigawatt Strom. Zum Vergleich: Alle Rechenzentren in den USA könnten bald knapp 4,4% des landesweiten Stromverbrauchs beanspruchen. Das bringt steigende Kosten mit sich, die zur harten Nuss für die KI-Entwicklung werden könnten.

Photonische Chips: Ein Lichtblick?

Photonische Chips kommen hier ins Spiel. Diese Chips nutzen Lichtwellen statt Elektronen, um Berechnungen durchzuführen. Dadurch könnten bestimmte Operationen in neuronalen Netzwerken bis zu 1000 Mal effizienter werden. Ein kleiner technischer Dreh am Rad, der große Auswirkungen haben könnte.

Soweit die Theorie. Doch bevor wir die Sektkorken knallen lassen, müssen diese Chips ihre Alltagstauglichkeit unter Beweis stellen.

Ein konkreter Tipp: Unternehmen sollten frühzeitig evaluieren, ob photonische Chips für ihre KI-Vorhaben sinnvoll sind. Hier ist etwas Weitsicht gefragt, denn Energieverbrauch kann schnell zum Kostentreiber werden.

Zusammengefasst: Der steigende Stromverbrauch durch KI ist eine Herausforderung, die neue Technologien wie photonische Chips adressieren könnten. Unternehmen, die zukunftssicher arbeiten wollen, sollten in Energiespartechnologien investieren oder auf solche Entwicklungen setzen.